Veille SEO 2021, semaine 40

Nous sommes la 40ème semaine de l'année…

... et cette semaine, je dois vous expliquer quelque chose. Pour chaque édition, j'ai toujours eu envie de commenter chaque lien en allant un peu plus loin, peut-être même en faisant un article sur notre blog. Cette semaine, j'ai décidé de couper la poire en deux. Préparez-vous un double expresso, je fournis la tartine.

Bonne lecture, et n'oubliez pas de vous amuser !

- Google a mis à jour sa documentation officielle en ajoutant des conseils à l'attention des propriétaires de sites de vente.

- En utilisant SplitSignal, Semrush a publié une étude sur le fait d'ajouter "Mis à jour le [date]" dans les Titles d'une marketplace. Boom : le nombre de clics enregistrés à explosé.

- Olivier Duffez nous parle des pages qui refusent de s'indexer.

- Yoast conseille de ne plus utiliser les Tags de WordPress

- L'agence Search Foresight explique comment un podcast peut venir compléter votre positionnement SEO

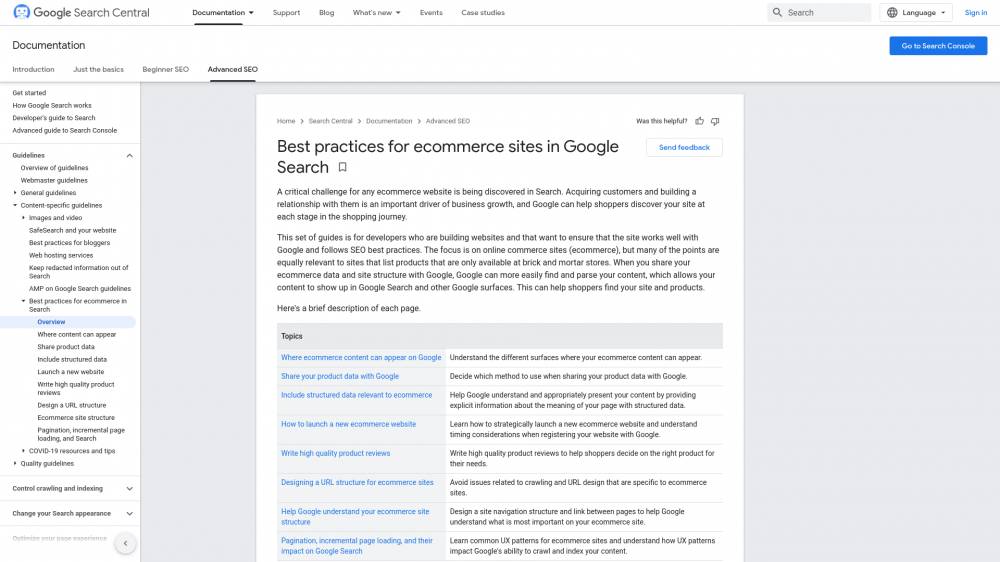

Google a mis à jour sa documentation officielle en ajoutant des conseils à l'attention des propriétaires de sites de vente.

Qu'ils fassent de la vente en ligne ou uniquement en magasin physique, on sent qu'en ce moment, Google a l'oeil rivé sur les commerces.

Dans ces pages, on retrouve de nombreuses références au "Merchant Center", la technologie qui permet aux webmasters de tenir à jour les données en rapport avec leurs produits sur Google.

Et il semble logique de penser que le géant de Mountain View aimerait vraiment que tout le monde s'y mette: en lui envoyant, dans son format propriétaire, toutes les mises à jour concernant vos produits (descriptions, prix, stocks, etc), vous lui épargnez le travail de titan qui consiste à rafraîchir son index en quasi-temps réel (quand ça marche).

En échange, il ne serait pas stupide d'espérer une rétribution en trafic, via une meilleure visibilité (au sens large : encarts spéciaux, positions améliorées) pour ceux qui joueront le jeu.

En utilisant SplitSignal, Semrush a publié une étude sur le fait d'ajouter "Mis à jour le [date]" dans les Titles d'une marketplace. Boom : le nombre de clics enregistrés à explosé.

![En utilisant SplitSignal, Semrush a publié une étude sur le fait d'ajouter "Mis à jour le [date]" dans les Titles d'une marketplace. Boom : le nombre de clics enregistrés à explosé. sur Semrush.com](https://soumettre.fr/storage/img/veille-seo/7207a09d08925954ce0c2cac1ab885be.jpg)

On parle bien de clics d'utilisateurs (CTR) et pas de positions gagnées (SEO). Quand même, 18% d'augmentation pour un changement aussi peu impactant, c'est un quick win.

Bien sûr, il faut que le site s'y prête (avec des mises à jour nombreuses et régulières). Mais ce qui m'intéresse surtout dans cette étude, c'est la méthodologie employée, très proche de la méthode scientifique. Semrush se sert de cette occasion pour promouvoir SplitSignal, sa plateforme d'A/B testing spécialement pensée pour les référenceurs (non, cette newsletter n'est pas sponsorisée).

Je suis particulièrement fan du format, on dirait une publication scientifique. Ils commencent par des constats sur l'existant (notamment les algorithmes "fresh results" qui évoluent depuis 2011). Ensuite, ils proposent une hypothèse ("La mise en avant de la date de mise à jour récente devrait aider à attirer plus de trafic").

Pour esayer de la réfuter, il faut alors constituer deux groupes : le groupe testé, avec des pages qui seront modifiées, et le groupe de contrôle, avec des pages qu'on ne touchera pas.

Le test consiste alors à mettre en évidence des différences flagrantes (on dit "significatives") entre ces deux groupes.

Si, à la fin du test, les deux groupes ont à peu près le même volume de clics, on devra reconnaître qu'on "n'a pas pu mettre en évidence de corrélation entre la mise à jour du title et le CTR". Vous remarquerez les précautions à prendre : on n'a pas réussi à démontrer que ça avait un impact, ce n'est pas la même chose que dire "on a montré que ça n'avait aucun impact".

Si on échoue suffisamment longtemps (et dans des circonstances différentes : sur une marketplace, sur un blog, sur un site statique, avec ou sans cache, etc), on pourra finalement conclure qu'il n'y a aucun rapport.

Il faut aussi faire attention à la surinterprétation : même si l'étude montre une corrélation entre la mise à jour du Title et l'augmentation du CTR, il est encore tout à fait possible que la date de la mise à jour de la page n'ait pas d'impact, et que Google (ou les utilisateurs) préfèrent juste cliquer sur des titres plus longs, par exemple.

D'autres tests seraient nécessaires pour vraiment en avoir le coeur net.

Olivier Duffez nous parle des pages qui refusent de s'indexer.

Le déroulé est impeccable: Olivier nous expose d'abord que Google communique officiellement sur le fait que si une ou des pages de votre site ont du mal à être indexées, ce n'est pas un bug, mais une volonté délibérée du moteur. Celui-ci considère la qualité globale de votre site pour essayer de prédire (ça sent le machine learning) si le crawl d'une page vaut le coût ou pas, avant de dédier un robot à son exploration.

Olivier montre aussi comment lister les pages "Explorée, actuellement non indexée" et "Détectée, actuellement non indexée", depuis la Search Console.

Il fait ensuite la promotion de son outil Ranking Metrics, qui calcule un "Quality Risk". En étudiant près de 3000 sites, Olivier met en évidence une corrélation entre un QualityRisk bas et une probabilité d'apparition dans les SERPs élevée.

Pour les pages moyennes (QR entre 10 et 60), l'algorithme n'a pas l'air d'une précision monstrueuse, mais on voit clairement une grosse différence entre les sites sous 10, ceux entre 10 et 60, et ceux au-dessus de 60.

La conclusion semble s'imposer : la qualité générale d'un site entre bien en ligne de compte au moment de décider si une page sera crawlée et indexée ou pas.

Là où mon avis diffère de celui d'Olivier, c'est qu'il semble penser que Google ne fait pas ça pour réduire ses coûts de fonctionnement. Pourtant, si demain, j'étais nommé CTO chez Google (note pour les RH: on peut en parler mais seulement si vous acceptez le télétravail), une grosse moitié de mon boulot serait d'optimiser l'utilisation de la gigantesque machine qui doit garder une copie du web entier à jour.

Pour cela, tous les moyens seraient bons, de la promotion du format AMP (qui consiste, en gros, à épurer un peu les balises HTML d'une page), jusqu'à la mise en avant des Core Web Vitals, arrivée avec l'update Page Experience.

Ne cédons pas au bullshit pro-utilisateur du moteur : cette communication me semble exagérée pour un update qui a eu une portée somme toute assez modique pour le moment. Si une page met deux secondes à être crawlée, mon robot sera utilisé pendant deux secondes. Si on n'avait que des pages qui demandent moitié moins de temps, on pourrait théoriquement en crawler le double pendant la même période, et donc, soit crawler deux fois plus de pages par jour, soit payer moitié moins de serveurs. Je ne peux même pas imaginer le gain financier que cela pourrait représenter à l'échelle d'un mastodonte pareil.

Yoast conseille de ne plus utiliser les Tags de WordPress

Pour les deux du fond qui dorment : sur WordPress, les Tags sont un moyen de regrouper les posts qui parlent d'un même sujet.

Yoast, éditeur du bien connu plugin SEO du même nom, conseille carrément d'arrêter de s'en servir.

Comme d'habitude avec eux, l'intention est bonne mais le conseil l'est moins.

Ils ont raison sur le point principal : pour chaque tag ajouté à votre blog, WordPress créé une nouvelle page, qui reprend par défaut le début de chacun des articles qui portent ce tag.

Avec le temps, ces pages Tag vont s'accumuler, obligeant Google à faire plus d'efforts pour crawler votre site, ce qui pourrait (pourra) le lasser. Ces pages étant "thin" (pauvres en contenu unique), le ressenti global de la qualité de votre site finira par s'en ressentir.

Par contre, au lieu de dire aux gens de dégager ces pages en masse, je serais plus tempéré.

Le problème principal étant que ces pages sont pauvres en contenu, il serait pertinent d'ajouter un texte SEO sur chacune, pour détailler pourquoi ce tag est important dans votre business.

Ensuite, vous devriez ne garder que deux ou trois tags par post, en faisant en sorte de réutiliser le plus possible des tags déjà existants. Les pages Tag étant souvent liées depuis les pages des Posts (c'est votre thème qui décidé, mais c'est une pratique très courante), ça donne un moyen de rapprocher des pages qui abordent les mêmes sujets entre elles (par le maillage interne de type "post -> tag -> autres posts").

Pour les pages que vous auriez créé en trop, il faudrait soit les rediriger vers le post (ou la catégorie) le plus pertinent, soit les mettre en 404 (page introuvable) ou encore en 410 (définitivement disparue).

Il pourrait aussi être pertinent d'utiliser un plugin comme YARPP (Yet Another Related Posts Plugin) ou équivalent, qui proposera directement des "posts associés" sur la page de votre article, zappant la page de tag à l'occasion, et les rapprochant encore plus.

Bref, le conseil de Yoast n'est pas stupide, mais il faut poser une vraie réflexion SEO autour de ces pages de Tag au lieu de les condamner sans autre forme de procès.

L'agence Search Foresight explique comment un podcast peut venir compléter votre positionnement SEO

Et l'idée est bonne : en proposant un flux RSS des épisodes de votre podcast, vous permettez au moteur d'indexer directement vos fichiers audio, et vous vous incrustez dans des pages de résultats, même assez compétitives, pourvu qu'elles comportent un encart Podcasts.

J'aurais aimé que l'article intègre les podcasts dans une stratégie COPE (“create once, publish everywhere") : en recyclant, par exemple, des contenus textuels en épisode de podcasts, vous pourriez toucher une cible supplémentaire (plutôt CSP+ urbains de 40 ans et plus) à "moindre frais".

Le principe du COPE, c'est d'utiliser tous les formats possible pour pousser un contenu. Par exemple, certains d'entre vous lisent cette veille dans leur inbox, d'autres viennent la lire sur le site. On pourrait décliner ça en vidéo sur Youtube, en Podcast, et en slides (à partager sur Slideshare et consorts), pour toucher à chaque fois un public différent.

Les avantages en SEO sont assez peu nombreux (hormis le fait de squatter les SERPs et d'ajouter des pages qualitatives à votre site). Par contre, le COPE devient une arme redoutable (bien que chronophage) si elle est appliquée à une stratégie de Brand Awareness (améliorer la notoriété de votre marque - ça viendra forcément impacter son CTR, par exemple).

Un bémol toutefois : chaque nouvelle plateforme que vous attaquez a des codes bien à elle, et vos contenus y seront bien reçus si et seulement si vous arrivez à vous approprier les codes en question.