Veille SEO 2021, semaine 18

Nous sommes la 18ème semaine de l'année…

et cette semaine, pas de "fil rouge". Normal: le web parle encore de "Core Web Vitals" et de la prochaine mise à jour de Google, sans qu'on aie plus d'informations.

Bonne lecture, et n'oubliez pas de vous amuser !

- **Joy Hawkins**, consultante SEO au Canada, a publié un retour d'expérience à propos d'un avocat dont le site avait de nombreuses pages par ville. Dans son cas, le fait de retirer les pages a carrément boosté les positions de l'ensemble du site, notamment en Local Pack. Ça s'explique par le fait que les pages étaient de faible qualité et que leur contenu était très similaire. Bref, l'article nous invite surtout à nous demander comment on devrait prioriser les contenus qui apportent de la valeur à nos visiteurs, plutôt que des pages à la chaîne "pour ranker".

- Une étude de SearchMetrics à propos des Core Web Vitals (je résume: indicateurs de Google pour savoir si votre site propose une bonne expérience, notamment en termes de vitesse d'affichage) portant sur plus de deux millions de pages web qui se positionnent sur Google (sur les deux premières pages) au Royaume-Uni, en Allemagne et aux États-Unis a indiqué que seulement 4% des sites testés obtenaient statut "Bon" dans toutes les catégories. Intéressant : ils ont remarqué une grosse corrélation entre les pages les mieux classées et celles qui rankaient le mieux, ce qui indique que Google récompense déjà les pages qui chargent le plus rapidement. Le test qui est actuellement le plus difficile à passer est celui du CLS (Cumulative Layout Shift), qui détecte si des éléments de votre page se décalent pendant son chargement.

- Dans la **Search Console** de Google, il est possible de "désavouer" des liens. Ça revient à expliquer à Google quels liens vous souhaitez qu'il ne prenne pas en compte. **Tom Capper** nous livre un retour d'expérience assez tranché : à moins que Google vous indique que votre site est pénalisé manuellement pour liens entrants factices, vous ne devriez pas désavouer vos liens.

- Sur Twitter, **Google** annonce un nouvel outil, disponible pour les webmasters US (et bientôt déployé partout) pour signaler des soucis d'indexation sur nos sites. Google subit des bugs d'indexation depuis au moins 2018 ; s'ils en arrivent à sortir un outil dédié, j'ai bien peur qu'on ne soit pas sortis de l'auberge.

- Dans son **Webspam Report 2020**, Google explique qu'en utilisant l'IA, ils ont amélioré leur capacité de détection du spam de plus de 50 %, et qu'ils ont retiré 80 % des sites spammy qu'ils avaient dans leur index il y a quelques années (Les mauvaises langues remarqueront que les sites spammy sont rarement en ligne pendant de longues périodes). Ce qui est visé, c'est surtout les sites full-duplicate (copies d'un ou de plusieurs sites) et le "hack spam", où des contenus de très basse qualité sont publiés en masse sur des sites en profitant de failles de sécurité. Ça donne quand même le tournis : 40 milliards de pages de spam chaque jour, ça fait quasiment demi-million par seconde, et 1.460.000.000.000.000 par an.

- **Matthieu Verne** (qui a une des plus belles barbe de notre industrie) nous explique comment réussir son storytelling, en sept étapes.

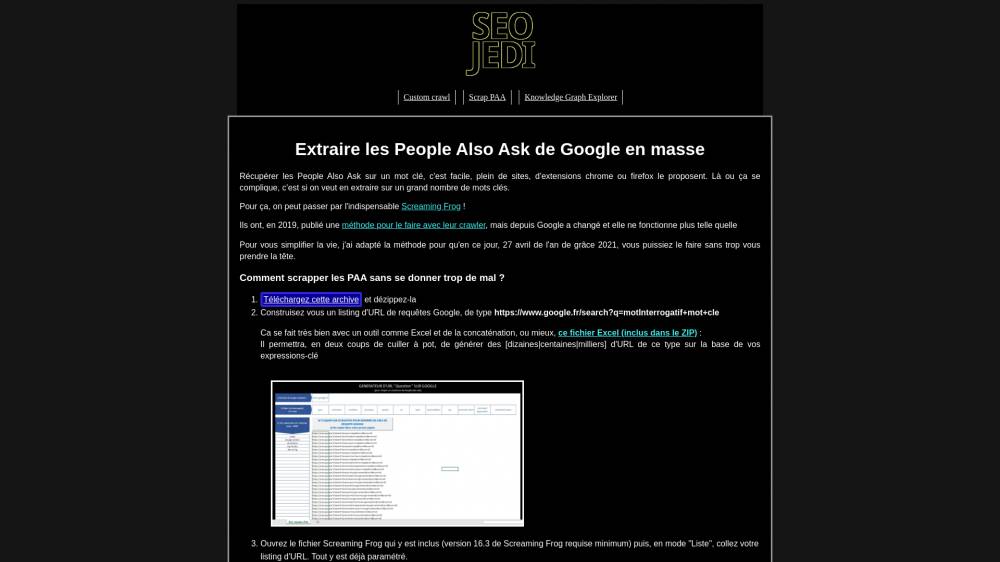

- Et pour finir, **Nicolas Le Gall**, de Yumens (anciennement MediaVeille) a bricolé un mini-outil permettant, en s'appuyant sur ScreamingFrog, de scraper des "People Also Ask" en masse. Ça se passe de commentaires...

Joy Hawkins, consultante SEO au Canada, a publié un retour d'expérience à propos d'un avocat dont le site avait de nombreuses pages par ville. Dans son cas, le fait de retirer les pages a carrément boosté les positions de l'ensemble du site, notamment en Local Pack. Ça s'explique par le fait que les pages étaient de faible qualité et que leur contenu était très similaire. Bref, l'article nous invite surtout à nous demander comment on devrait prioriser les contenus qui apportent de la valeur à nos visiteurs, plutôt que des pages à la chaîne "pour ranker".

Une étude de SearchMetrics à propos des Core Web Vitals (je résume: indicateurs de Google pour savoir si votre site propose une bonne expérience, notamment en termes de vitesse d'affichage) portant sur plus de deux millions de pages web qui se positionnent sur Google (sur les deux premières pages) au Royaume-Uni, en Allemagne et aux États-Unis a indiqué que seulement 4% des sites testés obtenaient statut "Bon" dans toutes les catégories. Intéressant : ils ont remarqué une grosse corrélation entre les pages les mieux classées et celles qui rankaient le mieux, ce qui indique que Google récompense déjà les pages qui chargent le plus rapidement. Le test qui est actuellement le plus difficile à passer est celui du CLS (Cumulative Layout Shift), qui détecte si des éléments de votre page se décalent pendant son chargement.

Dans la Search Console de Google, il est possible de "désavouer" des liens. Ça revient à expliquer à Google quels liens vous souhaitez qu'il ne prenne pas en compte. Tom Capper nous livre un retour d'expérience assez tranché : à moins que Google vous indique que votre site est pénalisé manuellement pour liens entrants factices, vous ne devriez pas désavouer vos liens.

Sur Twitter, Google annonce un nouvel outil, disponible pour les webmasters US (et bientôt déployé partout) pour signaler des soucis d'indexation sur nos sites. Google subit des bugs d'indexation depuis au moins 2018 ; s'ils en arrivent à sortir un outil dédié, j'ai bien peur qu'on ne soit pas sortis de l'auberge.

Dans son Webspam Report 2020, Google explique qu'en utilisant l'IA, ils ont amélioré leur capacité de détection du spam de plus de 50 %, et qu'ils ont retiré 80 % des sites spammy qu'ils avaient dans leur index il y a quelques années (Les mauvaises langues remarqueront que les sites spammy sont rarement en ligne pendant de longues périodes). Ce qui est visé, c'est surtout les sites full-duplicate (copies d'un ou de plusieurs sites) et le "hack spam", où des contenus de très basse qualité sont publiés en masse sur des sites en profitant de failles de sécurité. Ça donne quand même le tournis : 40 milliards de pages de spam chaque jour, ça fait quasiment demi-million par seconde, et 1.460.000.000.000.000 par an.

Matthieu Verne (qui a une des plus belles barbe de notre industrie) nous explique comment réussir son storytelling, en sept étapes.

Et pour finir, Nicolas Le Gall, de Yumens (anciennement MediaVeille) a bricolé un mini-outil permettant, en s'appuyant sur ScreamingFrog, de scraper des "People Also Ask" en masse. Ça se passe de commentaires...