Veille SEO 2022, semaine 23

Nous sommes la 23ème semaine de l'année…

... et cette semaine, je prépare cette édition pendant le lundi de Pentecôte. J'hésite entre me sentir comme Caliméro, parce que "c'est vraiment trop injuste" de travailler quand les autres se reposent, ou comme Batman, qui veille au grain pendant que les citoyens de Gotham dorment sur leurs deux oreilles.

Bonne lecture, et n'oubliez pas de vous amuser !

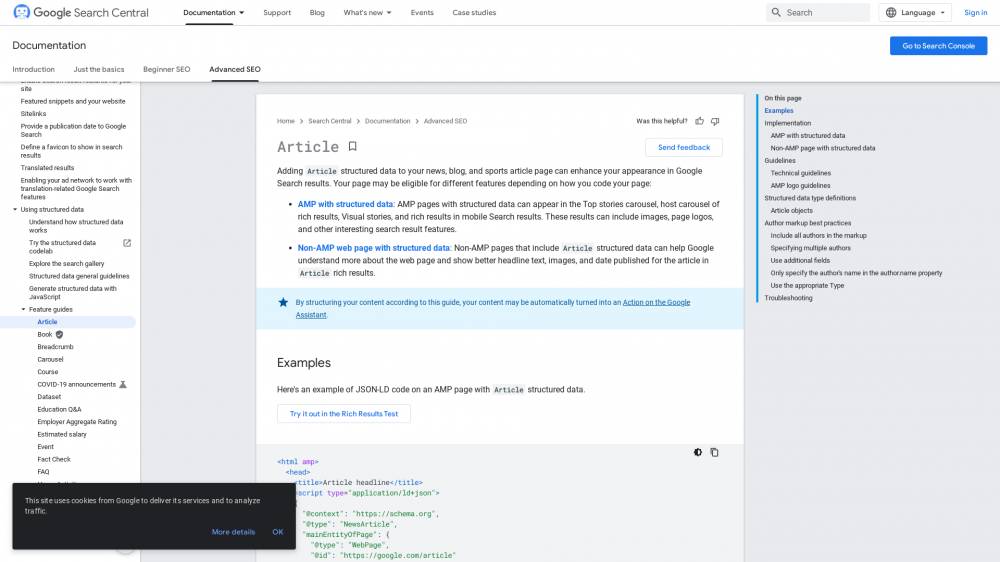

Données structurées : mise à jour de Author

On en parlait pas plus tard que la semaine dernière, Google adore les données structurées, ces bouts de code qui lui permettent de mieux comprendre le sens d'une page sans qu'il doive "deviner" où est quelle information.

Cette semaine, Google a mis à jour ses recommandations concernant Author, le système de balisage qui concerne l'auteur d'un contenu, en y ajoutant des champs supplémentaires, et plus généralement Article, qui concerne un article (comme son nom l'indique).

Ces champs sont facultatifs, mais il me semble évident, vu le peu de travail que ça demande, qu'il faudrait prévoir une petite session de quelques heures avec un développeur pour mettre vos templates à jour.

Par exemple, vous pourriez spécifier le logo de l'entreprise qui héberge le contenu, ainsi que le poste de la personne qui l'a rédigé.

Refonte de notre catalogue de liens

La première offre de Soumettre.fr, c'est le netlinking, où l'équipe choisit le spot. On le fait toujours (je suis assez fier de l'algo qui pré-sélectionne des sites-candidats), mais certains clients veulent avoir la main à 100% sur leur campagne.

Pour eux, on a mis en place un Catalogue, avec des critères de tri (dont les metrics habituelles).

Cette semaine, on a mis en production la nouvelle version : cherchez les spots qui se positionnent sur un mot-clé. Vous pourrez y acheter un article tout neuf, en étant certain que le spot travaille sur la même thématique que vous !

+110% de trafic en réglant les problèmes de cannibalisation

La cannibalisation, c'est ce qui se passe quand plusieurs pages de votre site pourraient se positionner sur le même mot-clé.

Soit Google hésite et finit par "partager" la puissance des pages (diminuant leur capacité à atteindre les sommets des SERPs), soit c'est juste que vos efforts internes sont partagés entre les pages, rendant vos campagnes moins efficaces.

Bref, c'est un problème qu'il faut régler.

Dans cet article, Andy Chadwick détaille le cas concret d'un site d'immobilier en Californie, de plus de 50 millions de pages, et une navigation interne non optimale.

Par exemple, le site avait une page "villa les pieds dans l'eau" et une autre "maison au bord d'un lac".

Chad explique la méthodologie : ils ont créé une énorme liste de tous les mots-clefs qu'ils visaient, et on récolté, pour chaque mot-clé, quelles étaient les URLs du site qui ressortaient dans Google.

Pour chaque mot-clé pour lequel ils ont trouvé plusieurs pages, ils avaient un problème de cannibalisation à régler.

Les résultats sont bons, +110% de trafic, avec un bémol : on voit sur la courbe du site que son trafic était déjà sur une tendance à la hausse, longtemps après ce chantier.

Dans tous les cas, cette cannibalisation devient souvent un vrai souci dès que votre site fait quelques milliers de pages, et l'article vous aidera à y réfléchir.

Google ne comprend plus rien au SEO

Olivier Andrieu a relevé un thread Twitter de Gianluca Fiorelli, qui raconte qu'une de ses amies a suivi une formation SEO sur Coursera intitulée "Digital Marketing et E-commerce". Sous la forme d'une formation pour débutants donnée par Google lui-même, on s'attendrait à avoir une resucée des Guidelines, mises à portée d'un débutant.

Sur la slide 24, Google explique comment éviter le "keyword stuffing", situation dans laquelle on insiste lourdement sur un mot-clé, jusqu'à l'abus (et c'est contre-productif, du moins aujourd'hui).

Google explique que les pages doivent contenir au moins 300 mots, que la densité des mots-clés par rapport au total du contenu ne doit pas dépasser 2% (qui serait le "standard de l'industrie") et compagnie.

Suite à une demande d'éclaircissements auprès de Danny Sullivan (qui fait officiellement la liaison entre Google Search et le public), la slide est obsolète, n'a pas été écrite par l'équipe Search ou quelqu'un d'affilié, et doit être ignorée. Elle a d'ailleurs été retirée de la formation moins de 24 heures après cette histoire.

Comme le dit Olivier, ça a au moins le mérite de démontrer qu'en SEO, on ne doit pas prendre tout ce qui sort de chez Google comme argent comptant.

Automating Ourselves Out of Existence

Vous vous rappelez du SEO Book ? Pour les plus jeunes : c'était un PDF de 300 pages, qui récapitulait toutes les bases du SEO. Ça expliquait tous les concepts, avec des détails sur les parties complexes (structure interne avec pagination, etc).

Pour vous dire à quel point c'était une référence, c'est par ce PDF qu'on m'a demandé de commencer quand je me suis mis au SEO, fin 2007. Alors certes, j'étais censé coder des outils internes pour une agence, mais quand même. À lui seul, Aaron Wall avait mis en place un incontournable.

Aujourd'hui, Aaron a publié un billet d'humeur sur l'automatisation à outrance et sur ses répercutions sur nos vies.

On y apprend qu'il a eu un enfant entre-temps (tiens, moi aussi) et qu'il vit au Vietnam (tiens, pas moi).

Le billet est intéressant, mais pour être franc, quand j'ai vu son icône dans mon lecteur de flux RSS, j'ai eu l'impression de recevoir une carte postale d'un vieux pote oublié.

HelloWork fusionne 11 sites

HelloWork est un groupe d'édition de sites orientés "recherche d'emploi" (disclaimer: ils possèdent aussi le BlogDuModerateur, qui publie l'article dont on parle). Au fil du temps, ils ont fini par disposer de 11 sites différents... et on décidé de les fusionner, pour n'en garder qu'un, ce qui permettra de consolider leur présence dans les SERPs et la notoriété de leur marque.

L'article donne la parole à Rodolphe Morfoise-Gauthier, product owner chez HelloWork, et Fabien Bougault, responsable SEO.

En toute transparence, ils y discutent de la stratégie qu'à adoptée la marque, et de la méthodologie qui a été adoptée pour que la transition se passe en douceur.

Les plus aguerris des SEO qui me lisent n'y apprendront peut-être pas grand chose, mais autant vous dire tout de suite que ça a été fait proprement, avec une vision claire des risques et des enjeux.

Ahrefs lance Yep, son moteur de recherche

... enfin, pour être plus précis, Ahrefs essaie de relancer la hype autour de son moteur de recherche, dont on entend parler régulièrement depuis 2019. Sauf que cette fois, il est en ligne !

Le développement du moteur a coûté 60 millions de dollars. Les résultats sont tirés de l'index propriétaire de Ahrefs (et non pas sur une API vers Bing ou Google).

Grosse proposition de valeur: Yep reverse 90% de ses revenus publicitaires aux créateurs de contenu. D'après eux, c'est le meilleur moyen de faire vivre des sites comme Wikipedia, d'éliminer les Paywalls, de ralentir l'affiliation (puisque vous seriez payés dès que l'internaute arrive sur votre site).

Ce qui est assez marrant, c'est que mon beau-frère Hervé me tenait EXACTEMENT ce discours pas plus tard que Dimanche. Il me disait qu'un partage équitable des revenus était l'unique solution à long terme pour dépolluer le web. Dans sa vision, les éditeurs devaient gardé une grosse part des revenus qu'ils génèrent (90%) et les différents intervenants techniques, ayant accès à "tout le gâteau", devraient se partager les 10% restant.

Franchement, je leur souhaite que Yep décolle et crève le plafond.

Le plus gros écueil dans leur vision, c'est qu'ils vont demander aux éditeurs de centraliser leurs revenus. Si demain, Wikipedia se casse la gueule dans leurs SERPs, c'est la mort assurée pour l'encyclopédie. Du coup, on a peu de chances de voir disparaître les bandeaux d'appels aux dons... Mais l'intention reste très louable !