Veille SEO 2025, semaine 46

Nous sommes la 46ème semaine de l'année…

... et cette semaine, on nage en plein délire : sur plus de 450 articles publiés sur mes sources, 95% au moins parlaient d'IA d'une manière ou d'une autre. On se rapproche des fêtes de fin d'année : attention à l'indigestion !

Bonne lecture, et n'oubliez pas de vous amuser !

llms.txt : une fausse bonne idée ?

Duane Forrester a participé à l'élaboration de Bing Webmaster Tools et de Schema.org

Aujourd'hui, il est consultant pour des entreprises qui veulent être visibles via les moteurs IA.

Il donne son avis sur le fichier llms.txt, censé être une porte d'entrée pour que les moteurs conversationnels comprennent le contenu de votre site.

Selon lui, c'est une fausse bonne idée : pas de standard, pas de gouvernance, donc fatalement peu d'adoption par les moteurs.

De ce que j'ai vu, en vrai, les seuls sites qui ont un fichier llms.txt pour le moment, ce sont des Wordpress qui utilisent des plugins comme Yoast ou All-In-One SEO, qui remplissent ce fichier par défaut.

Construire son autorité quand on part de zéro ?

On parle toujours d'EEAT. Facile à dire. Difficile à démontrer, d'autant plus quand on s'adresse à des machines.

Dans cet article, Claire Taylor essaie de décortiquer les mécanismes qui aident les moteurs à comprendre sur quoi vous êtes experts.

Ça va de "show, don't tell" aux clusters de contenus, en passant par des conseils pour une page auteur réussie.

Personnellement, j'ai beau prendre le sujet au sérieux, l'article m'a fait réaliser que j'ai encore plusieurs cases à cocher... Au travail !

SEO Multi-Location

Vous gérez le SEO pour une chaîne de franchises ou de magasins physiques ? Miriam Ellis a pensé à vous.

Petit guide pour bien démarrer son Store Locator : chaque succursale doit avoir sa page unique, enrichie d'éléments locaux, avec une fiche Google Business Profile au carré.

Pour maintenir tout ça, Miriam propose un fichier Excel qui centralise les informations (perso, j'aurais fait autrement, mais l'idée est bonne).

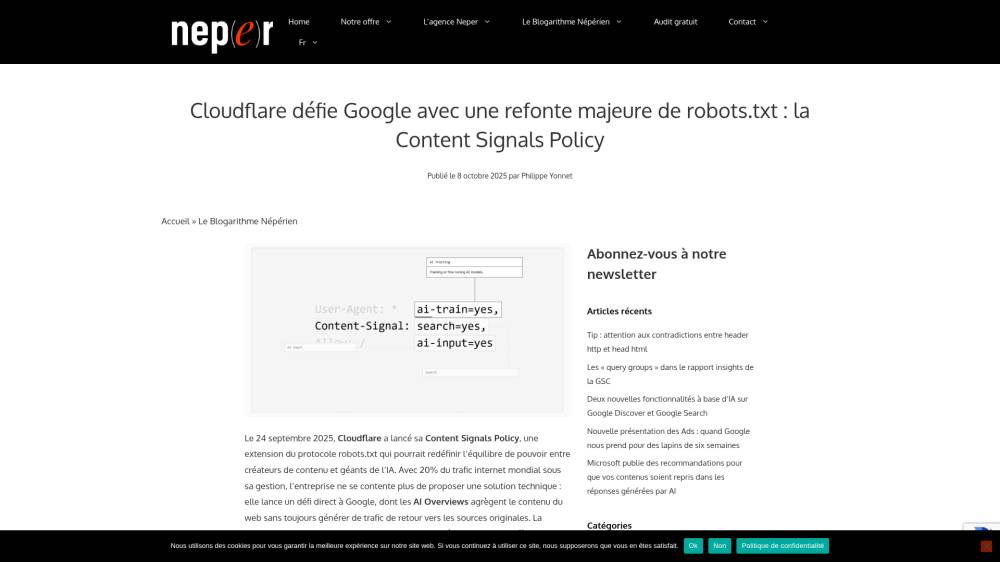

Cloudflare défie Google

Le fichier robots.txt repose sur un contrat implicite, "mon contenu contre du trafic", rompu les IA génératives.

Cloudflare propose un nouveau standard : la "Content Signals Policy", qui étend le robots.txt pour inclure trois signaux : "search" pour la recherche classique, "ai-input" pour les réponses IA en temps réel, et "ai-train" pour l'entraînement des modèles.

Google est la cible principale : son crawler historique, GoogleBot, étant aussi le crawler qui nourrit son IA.

La déclaration serait juridiquement contraignante, puisqu'elle fait référence à la Directive européenne sur le droit d'auteur.